Resulta un verdadero desafío hacerse una idea de la verdadera dimensión de los datos con los que trabajan las compañías que trabajan en el desarrollo de algoritmos de inteligencia artificial generativa, y algunos artículos recientes pueden servir de guía para ello.

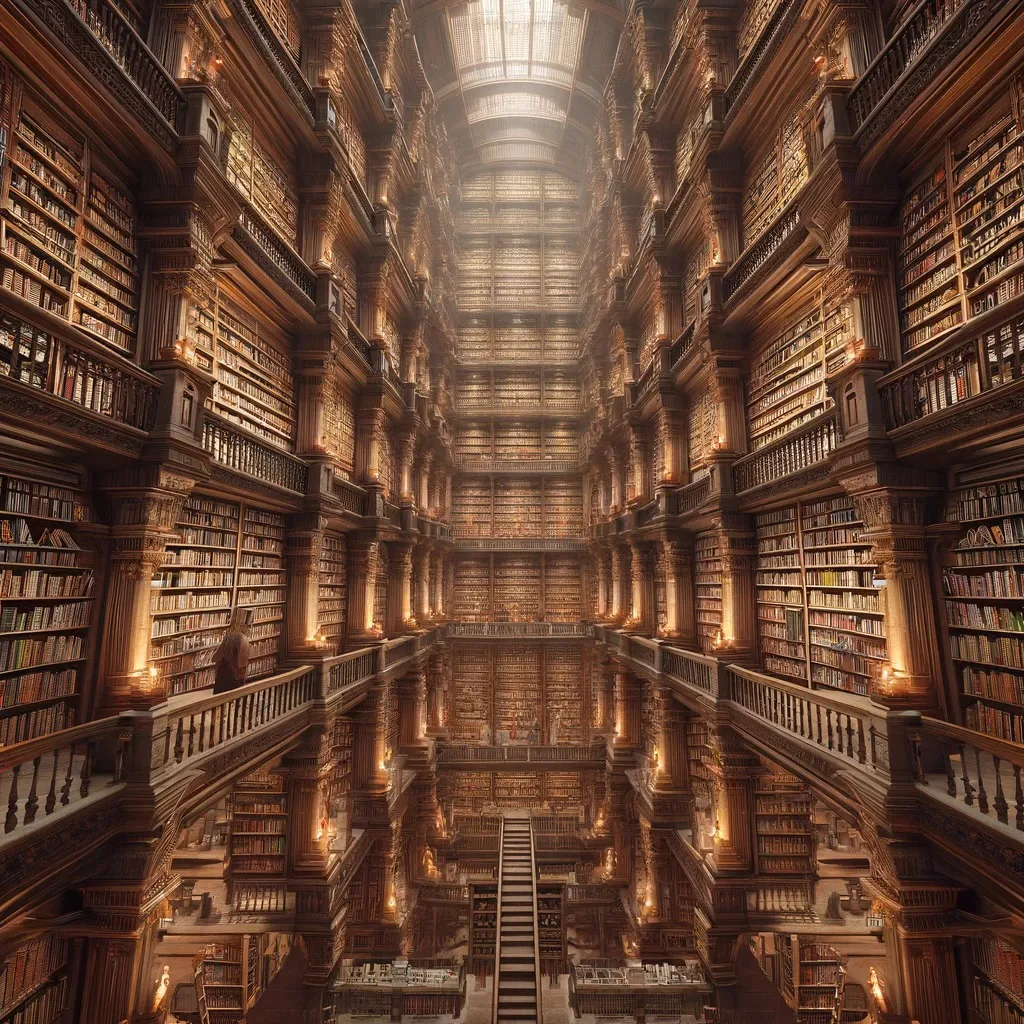

En The Verge, este artículo titulado «OpenAI transcribed over a million hours of YouTube videos to train GPT-4» ayuda a entender el nivel de desesperación que una compañía puede alcanzar a la hora de intentar obtener más y más colecciones de datos cuando ya prácticamente la totalidad de la internet considerada aprovechable ha sido incorporada de alguna manera a los datasets de entrenamiento: dedicarse a transcribir más de un millón de horas de vídeos de YouTube, una conducta, según la compañía, probablemente contraria a sus términos de servicio.

¿Dónde está el problema? Que en este momento, dadas las prisas por disponer de modelos bien entrenados y con cada vez más prestaciones, las compañías dedicadas a su desarrollo prefieren una aproximación del tipo «mejor pedir perdón que pedir permiso», es decir, optan por tomar todos los datos que puedan de todas las fuentes que puedan y llegar posteriormente a acuerdos económicos o a pagar multas cuando ya los modelos están razonablemente bien entrenados.

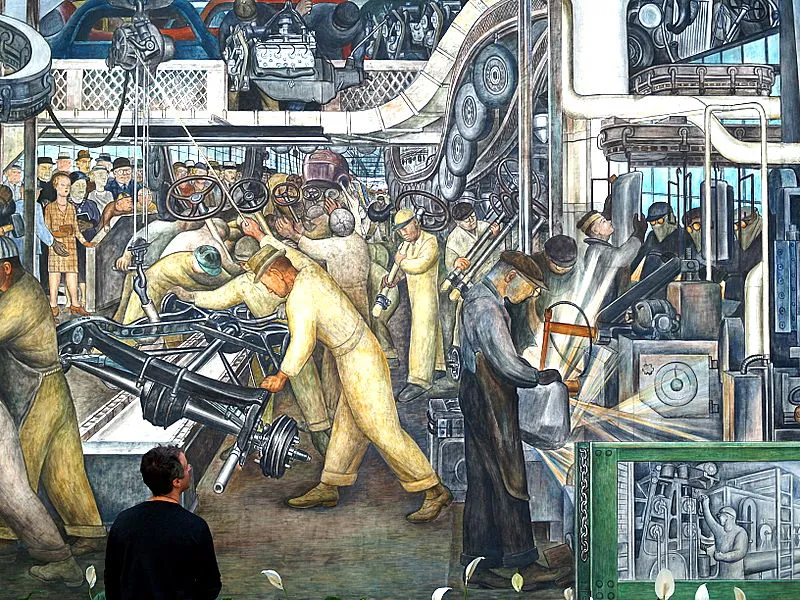

Ignorar políticas corporativas para asegurarse poder obtener datos de cualquier repositorio con posibilidades ha pasado a ser una prioridad tan elevada, que justifica prácticamente todo. Para entender esa alocada carrera, es muy interesante leer este artículo de The New York Times, «Four takeaways on the race to amass data for A.I.«, en el que una visualización de los datos empleados para entrenar a ChatGPT3 permite entender la magnitud de los datos obtenidos desde el año 2007 utilizando crawlers, que vienen a representar unos 410,000 millones de tokens, frente a los tan solo 3,000 millones de tokens que representa la totalidad de la Wikipedia. Frente a eso, el escaneado de libros supone un par de colecciones de 12,000 y de 55,000 millones de tokens sobre las que la compañía da muy pocos datos y que se supone son millones de libros publicados, o los 19,000 millones de tokens que se obtienen de tomar páginas de Reddit seleccionando aquellas que hayan recibido tres o más votos positivos, utilizados como un indicador de calidad.

Las dimensiones son tan absolutamente desmesuradas, que algunas compañías están comenzando a utilizar los denominados datos sintéticos, es decir, datos obtenidos de otros algoritmos, para alimentar con ellas los suyos. La cuestión de usar inteligencia artificial para entrenar la inteligencia artificial es compleja, porque puede dar lugar a errores que se consolidan a lo largo de los diferentes procesos de entrenamiento e inferencia, pero tiene un potencial teóricamente ilimitado y seguramente muy difícil de limitar, lo que lleva a que ejerza un atractivo muy interesante para muchas compañías.

Algoritmos que generan datos para entrenar a otros algoritmos: esto ya empieza a parecerse a los niveles de sueño anidados de la Inception de Christopher Nolan. Y por otro lado, nos permite poner en perspectiva los acuerdos a los que algunas compañías están llegando con, por ejemplo, periódicos con una larga andadura o cualquier cosa – absolutamente cualquiera – susceptible de generar datos. Si en la era del machine learning nos dedicábamos a trabajar con los datos para obtener repositorios razonablemente parsimoniosos, eliminar outliers injustificados y terminar generando modelos eficientes, ahora estamos más en una fase de «todo p’adentro» en la que lo único que importa es que el algoritmo resultante parezca tener una cierta calidad, sin entrar demasiado en detalles.

Una auténtica locura.

Nota:enriquedans.com/