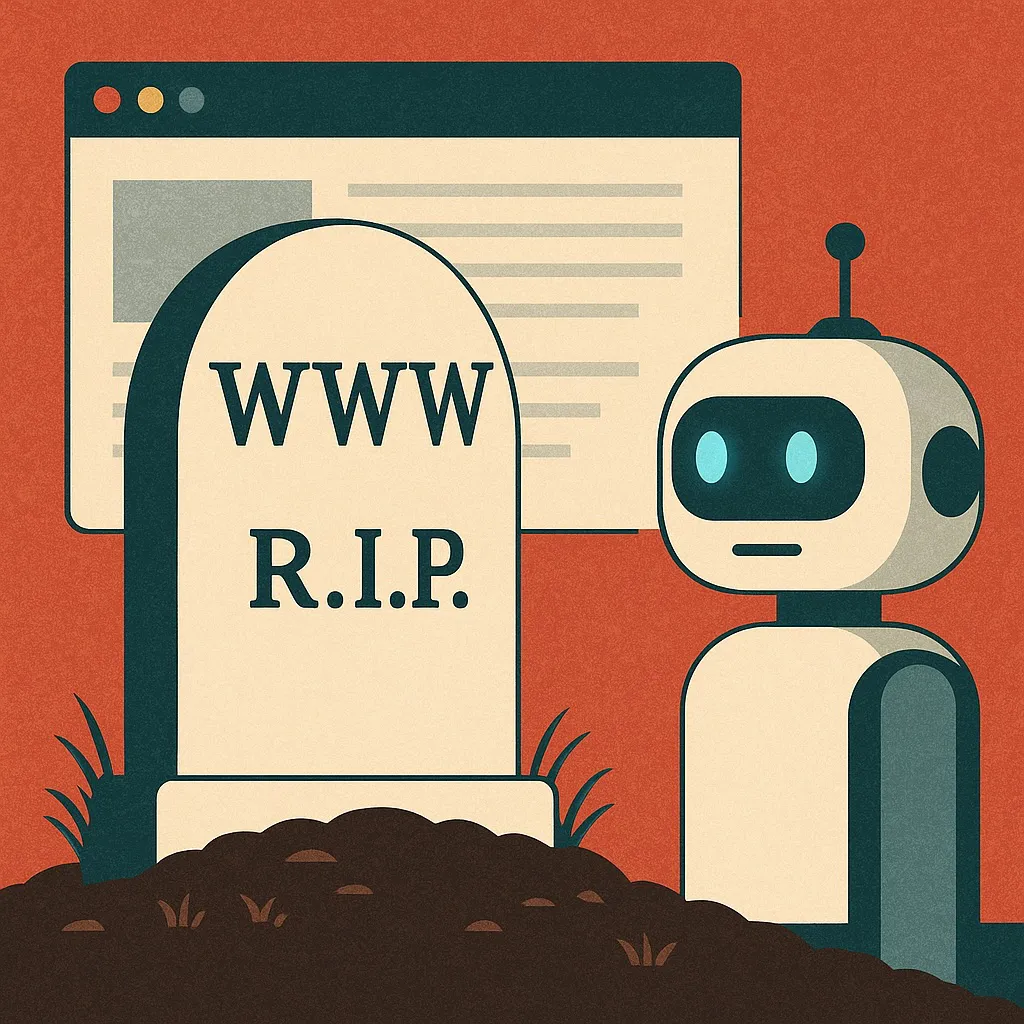

Que The Economist publique un artículo titulado «AI is killing the web. Can anything save it?» ya es en sí un anuncio simbólico: no de que ese medio vaya a desaparecer mañana, sino de que el consenso tecnológico parece estar en plena mutación. Pero movámonos con cierto cuidado: ¿realmente estamos ante la muerte de la web tal como la conocemos, o más bien, ante su metamorfosis radical?

El planteamiento central del artículo de The Economist es muy directo: los modelos de inteligencia artificial conversacional como ChatGPT y similares están erosionando el «verdadero acuerdo» que sostenía la web: los sitios entregaban contenido libremente, los motores lo indexaban, y luego los usuarios eran redirigidos hacia esos sitios para consumirlo (y así monetizarse mediante publicidad). Poca crítica o ninguna sobre los males de ese modelo, que ha supuesto, desde mi punto de vista, el verdadero problema en esa evolución de la web, que en manos de irresponsables nos ha convertido en productos en vez de usuarios, y que es el responsable de su posible muerte.

Los sistemas de inteligencia artificial, argumenta el artículo, rompen ese ciclo: ofrecen respuestas «ya digeridas» al usuario, sin necesidad de enviar ningún tráfico a páginas externas. En ese escenario, lógicamente, las páginas web pierden visitas, ingresos y relevancia. Si vives de las visitas y de la publicidad, mala cosa. Lo de la relevancia creo que merece otra reflexión diferente, pero esa la dejo para otro artículo.

Ante este panorama de pronunciamientos y reflexiones, quiero plantear mi propia hipótesis, crítica pero optimista, acerca de si la web como la conocemos está en su ocaso, o simplemente embarcada en una transición profunda: para empezar, creo que la afirmación de The Economist es más útil como provocación que como sentencia. No niego que muchos sitios, sobre todo aquellos cuya monetización dependía casi exclusivamente del tráfico referencial, ya están sintiendo el golpe. Pero «matar la web» habría sido una exageración incluso en el siglo XX: la web ha demostrado ser resiliente, ubicua y capaz de reinventarse.

Existen algunos argumentos presuntamente sólidos a favor de la tesis del colapso:

Desintermediación del «click»: si las inteligencias artificiales responden sin redirigir, los editores pierden visibilidad. Las webs que dependían de picos de tráfico «gratuito» pueden ver reducirse drásticamente su modelo de negocio. Modelos como Google Discover no hacen más que «repartir migajas» de un tráfico que se está desvaneciendo rápida y gradualmente.

Homogeneización del contenido y ruido algorítmico: si muchas respuestas provienen indirectamente de fuentes similares, el abanico de voces se estrecha. Además, los modelos pueden tender al «auto-plagio»: reutilizan lo ya consumido, no crean conocimiento original.

Concentración de poder en plataformas de inteligencia artificial dominantes: si tres o cuatro compañías controlan los grandes modelos y los «canales de entrega», podrían convertirse en los nuevos «portales de facto» de la información, desplazando a los sitios medianos e independientes.

Pero contra esos riesgos, apuesto algunos contra-argumentos que sugieren que la web no morirá, sino que podría emerger de otra forma:

El valor sigue en la especialización y la comunidad humana: los modelos de inteligencia artificial no pueden sustituir ciertas funciones: periodismo de investigación o investigación como tal, análisis original, comunidades nicho con voz humana y reputación. Allí, como en esta página que estás leyendo y cuyo tráfico no ha caído, la web conserva un espacio privilegiado y razonablemente humano. Lo del modelo de negocio es, si queremos, otra cuestión.

La reacción normativa y las licencias: es posible que surjan mecanismos legales o técnicos que obliguen a los agentes de inteligencias artificiales a pagar por acceso al contenido (licencias, micropagos, acuerdos). No me parecen para nada positivos porque apuntan a una mercantilización demencial de todo, pero existe ya preocupación institucional sobre cómo remunerar la producción de contenidos frente al uso masivo por los modelos.

Rediseño arquitectónico (Web 3.0, agentes, estándares): algunos trabajos académicos sugieren que el próximo estadio será una «web agéntica» donde los agentes autónomos negocien con webs, soliciten fragmentos relevantes, devuelvan créditos, etc. Básicamente, lo que proponen es una nueva fase de una internet dominada por agentes inteligentes que interactúan entre sí y con humanos, lo que convierte la navegación en una especie de danza entre máquinas. Según esto, los ideales de la web semántica, con datos estructurados, razonamiento, agentes, etc. quedaron relegados frente al auge del deep learning, pero podrían rescatarse ahora como una alternativa más sostenible al modelo de «inteligencia artificial como caja negra». Un informe reciente del W3C investiga el impacto sistémico de los modelos de machine learning sobre la estructura de la web, cómo la estandarización podría moderarlo, y apunta también a que una forma de evitar daños es incorporar estándares que permitan una «conciencia» del uso de contenido por inteligencia artificial dentro de la propia infraestructura de la web.

Crisis de sostenibilidad de la propia inteligencia artificial: Como advierte Forbes, si los modelos aprenden sobre contenido que ya estaba creado por inteligencia artificial, podríamos llegar a una suerte de «entropía textual» que degrade la calidad general del lenguaje generado y obligue a reintegrar fuentes humanas con mayor peso.

¿Cuál será el futuro si estos vectores siguen tensionándose sin resolverse? Mi escenario probable es híbrido: imaginemos que en diez años el «navegador conversacional» sea el punto de entrada predominante: el usuario pregunta, el agente de inteligencia artificial responde, pero bajo el capó, negocia microtransacciones con páginas web especializadas que ofrecen contenido protegido o de alto valor. Algunas webs se transforman en «ediciones premium para inteligencia artificial» o «para agentes, con APIs propias diseñadas para agentes. Muchas otras migran a modelos de suscripción o comunidades troceadas, independientes del tráfico abierto.

En ese mundo, sí, gran parte del Internet abierto, democrático y universal que conocemos se habrá diluido. Pero no será una muerte absoluta: más bien una reinvención forzada. Muchos pequeños sitios como blogs, páginas personales, revistas especializadas, etc. tendrán que repensar su papel: ser parte del ecosistema de agentes, no sólo esperar vistas gratuitas.

Así que, en mi juicio, no, la web no ha muerto todavía, pero sí ha dejado de existir tal como la conocimos. Nos hallamos, probablemente, al borde de su siguiente versión: una web de agentes, contratos y pagos invisibles. El reto será preservar diversidad, apertura y creatividad frente a la lógica del «más respuesta, menos enlace» que sin duda está surgiendo y creciendo a todos los niveles.

Y si me permitís una predicción provocadora, dentro de unos quince años, cuando alguien diga «visita mi página web», lo entenderemos más como «mi agente está disponible en esa plataforma» que como «entra a mi página». La verdadera pregunta no será si la web se muere, sino si podemos evitar que se convierta exclusivamente en una galaxia controlada por unos pocos motores de inteligencia artificial propiedad de unas pocas compañías que engañan y manipulan los algoritmos para que proporcionen las respuestas que ellos venden al mejor postor. Y ahí, los usuarios, su nivel de sofisticación y sus intereses tendrán mucho que decir.

Nota: https://www.enriquedans.com/