Cuando juzgar a la inteligencia artificial generativa por lo que sabe hacer hoy es un completo error

Actualidad04/06/2025

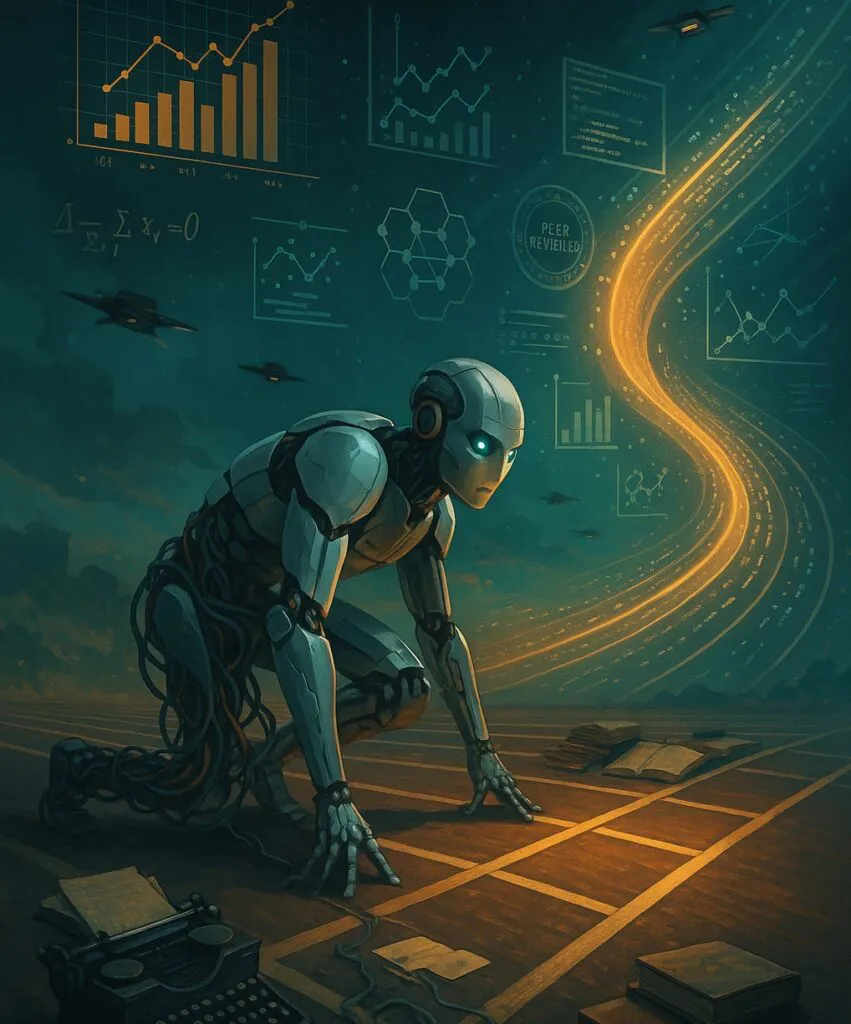

Una de las ideas más limitantes que podemos tener sobre la inteligencia artificial generativa es juzgarla únicamente por lo que es capaz de hacer hoy. Esta visión reduccionista o simplista, tan habitual como equivocada, aparece con frecuencia en los análisis superficiales, especialmente cuando se trata de tareas complejas como programar, investigar o escribir. Básicamente, «como lo probé e hizo algo mal, esto es una basura y lo va a ser siempre».

Pero juzgar una tecnología en rápido desarrollo por su estado actual es como juzgar la aviación por los primeros vuelos de los hermanos Wright: puede parecer sensato… pero es completamente miope.

Una crítica habitual y en parte razonable a la inteligencia artificial generativa proviene de voces como la del veterano desarrollador Thomas Ptacek, quien en su artículo «My AI skeptic friends are all nuts«, plantea que muchos entusiastas están sobrestimando lo que estos modelos son realmente capaces de hacer. Ptacek no niega su utilidad; al contrario, reconoce que son herramientas sorprendentes que transformarán muchos aspectos del desarrollo, pero su crítica va dirigida a quienes creen que la inteligencia artificial generativa ya puede reemplazar a un programador humano.

Para él, escribir código no es simplemente completar frases o generar funciones aisladas: es razonar sobre sistemas, manejar estados, entender arquitectura y mantener coherencia a lo largo del tiempo, tareas en las que, según su experiencia, los modelos actuales fallan estrepitosamente. Y, sin embargo, incluso en su escepticismo, hay un subtexto importante: la inteligencia artificial generativa no es inútil, simplemente aún no está lista. De nuevo, el error no está tanto en subestimarla… como en no proyectarla hacia lo que viene.

Mi experiencia con la inteligencia artificial generativa en el ámbito académico sigue un patrón muy similar. Cuando la intento utilizar como asistente para estructurar artículos académicos, su rendimiento es sorprendentemente bueno: formula hipótesis verosímiles, propone diseños metodológicos coherentes, redacta resúmenes claros y hasta sugiere discusiones y conclusiones con bastante fundamento. Pero en realidad, gran parte de todo eso está «en el aire», porque cuando se trata de recolectar datos reales, analizarlos rigurosamente o interpretar resultados empíricos, la herramienta se detiene en seco y no es capaz en absoluto de hacer el verdadero trabajo, la investigación como tal. Al menos por ahora, ni recopilar datos con garantías, ni analizarlos, ni nada de nada. Pero eso sí, cada vez que la pruebo de nuevo semanas o meses más tarde, observo una mejora tangible, como si la frontera de lo posible se desplazara sola, en silencio, mientras no miramos.

No podemos olvidar, además, que la inteligencia artificial generativa que hoy utilizamos tiene raíces técnicas muy claras: su arquitectura, desde el famoso paper «Attention is all you need«, está diseñada fundamentalmente para tareas como la traducción automática. En el fondo, su lógica básica sigue siendo «predecir la siguiente palabra», encontrar la secuencia lingüística más probable dada una entrada. Por brillante que esto sea para generar texto fluido y coherente, también impone limitaciones importantes cuando la tarea exige algo más que correlaciones léxicas: exige razonamiento, modelado causal, o comprensión profunda del contexto.

Es aquí donde empezamos a ver que, si bien los llamados «modelos de razonamiento» están intentando superar esa barrera, todavía estamos demasiado anclados en una lógica completamente lingüística. Incrementar la ventana de contexto ha sido una estrategia eficaz para mejorar las traducciones (del «palabra por palabra», al «frase completa», al «la totalidad del documento», y finalmente al «un montón de documentos de la misma temática»), la coherencia textual y la memoria a corto plazo, pero necesitamos proyectar ese concepto más allá del lenguaje. El reto ahora no es solo recordar más texto, sino construir modelos que entiendan sistemas complejos, manejen representaciones abstractas y puedan operar con datos estructurados, simulaciones o incluso entornos físicos. Extender el incremento de la ventana de contexto más allá del lenguaje. Sin ese salto conceptual, seguiremos teniendo sistemas que escriben muy bien… pero piensan más bien poco.

Esta dinámica se ha vuelto especialmente evidente en el mundo académico. En sus inicios, la inteligencia artificial generativa fue recibida con una mezcla de asombro y preocupación: ¿se usaría para fabricar papers falsos y saturar las revistas científicas con contenido basura? La respuesta inicial fue, efectivamente, sí: una oleada de papers generados de manera automática comenzó a llenar las bandejas de entrada de los editores, muchos de ellos plagados de errores, plagio y fórmulas vacías sin contenido real. El escándalo creció cuando algunos de esos textos lograron superar procesos de revisión por pares llevados a cabo de forma completamente superficiales, y colarse en conferencias y revistas de dudosa reputación.

Pero el panorama está cambiando. En marzo de este año, la startup japonesa Sakana causó revuelo al anunciar que uno de sus modelos había conseguido que un paper generado por inteligencia artificial generativa pasase un proceso de revisión por pares. En realidad el asunto es más matizado y complejo de lo que parece, pero revela una tendencia clara: la calidad de los trabajos generados por estas herramientas está mejorando. Ya no hablamos solo de «spam académico», sino de borradores técnicamente sólidos que podrían, con intervención humana, convertirse en contribuciones legítimas.

Más aún, la inteligencia artificial generativa no solo se está usando para escribir artículos, sino también para revisarlos. Algunas revistas ya están experimentando con modelos que ayudan a los revisores a evaluar papers, identificar inconsistencias o señalar referencias relevantes. No estamos simplemente automatizando la redacción científica: estamos replanteando todo el ciclo editorial, desde la escritura hasta la evaluación y publicación.

La figura que emerge de todo esto no es tanto la del «investigador reemplazado», sino la del «centauro académico»: humanos que se apoyan en la inteligencia artificial generativa para extender sus capacidades, pero sin ceder el control ni la responsabilidad. Es un nuevo pacto entre el pensamiento crítico humano y la velocidad, memoria y síntesis de las máquinas. No se trata de renunciar al rigor, sino de apoyarse en herramientas que lo potencien.

En este contexto, el debate sobre la validez de la inteligencia artificial generativa en tareas intelectuales deja de ser binario: no se trata de «sirve o no sirve», sino de entender en qué punto de su evolución estamos, y cómo podemos canalizarla de forma ética y efectiva. Como en todas las disrupciones, el peor error es pensar que la tecnología se quedará donde está hoy, porque no lo hará, y lo sabemos. Juzgar a la inteligencia artificial generativa por sus limitaciones actuales es como juzgar un avión por su capacidad para recorrer la pista: inútil, miope y condenado a quedarse en tierra.

Nota:https://www.enriquedans.com/