El desarrollo de la inteligencia artificial no se detiene, y ademas, está respondiendo a una enorme diversidad estratégica entre las compañías norteamericanas, empeñadas en una carrera permanente de acumular más procesadores en data centers cada vez más grandes, frente a unas compañías chinas que, privadas artificialmente del acceso a los procesadores más punteros, innovan mucho más en metodologías matemáticas y metodológicas.

Esto se hizo patente cuando vivimos el lanzamiento de DeepSeek en enero de este año, con un modelo más potente que ninguno de los norteamericanos del momento y entrenado con un coste muy inferior, pero acaba de volver a ponerse de manifiesto con la presentación de DeepSeek-V3.2-Exp, una evolución experimental de su arquitectura anterior.

Lo relevante de este anuncio no es tanto el salto numérico en la versión, sino la introducción de un fascinante mecanismo experimental llamado DeepSeek Sparse Attention (DSA), destinado a mejorar drásticamente la eficiencia tanto en el entrenamiento como en la inferencia, especialmente en escenarios de contexto largo. La compañía, además, ha acompañado este lanzamiento con una drástica reducción de precios en su API (un 50% menos), una estrategia que, combinada con su carácter abierto, supone un desafío muy potente para competidores como OpenAI, Anthropic o Google. El hecho de que DeepSeek opte por liberar sus modelos en código abierto, en contraste con la estrategia mayoritariamente cerrada con leves excepciones de las big tech occidentales, añade una dimensión geopolítica y estratégica interesantísima al debate sobre la democratización de la inteligencia artificial.

Pero lo que realmente convierte a esta propuesta en un cambio de paradigma no es su política comercial, sino su arquitectura. La evolución de la inteligencia artificial se enfrentaba hasta el momento a una paradoja: el mecanismo que sustenta sus mayores logros, el transformer enunciado en el famoso paper «Attention is all you need«, arrastra consigo una limitación fundamental: su mecanismo de autoatención obliga a calcular la relación entre todos los elementos de una secuencia, lo que se traduce en una complejidad cuadrática, n². Una idea adecuada para contextos cortos, pero prohibitiva en términos de recursos computacionales cuando hablamos de analizar libros enteros, grandes repositorios de código o largos documentos legales. En la práctica, es como intentar construir un rascacielos enorme sobre los cimientos de una casita unifamiliar.

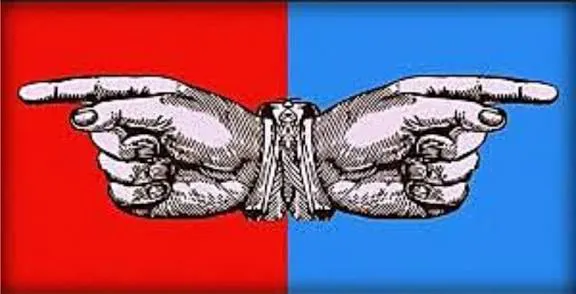

La propuesta de DeepSeek con su modelo de Sparse Attention es a la vez elegante y radical: abandonar la conectividad total de todos los elementos. El modelo plantea que no todos los elementos necesitan conectarse entre sí, sino únicamente con un subconjunto relevante y estratégico. Se sustituye así el ruido de fondo de una conversación caótica en la que todos hablan con todos por un diálogo eficiente entre especialistas.

En la práctica, esto se materializa con las llamadas arquitecturas de Mixture of Experts (MoE): en lugar de un modelo monolítico, encontramos un ecosistema de expertos, de redes neuronales más pequeñas y especializadas, que se activan de manera selectiva mediante un mecanismo de enrutamiento dinámico. El modelo completo puede acumular cientos de miles de millones de parámetros, pero cada entrada concreta activa solo a unos pocos expertos, lo que reduce drásticamente el coste computacional sin perder capacidad.

Este planteamiento altera la economía misma del escalado: deja de ser imprescindible apostar exclusivamente por la fuerza bruta, y abre la puerta a modelos capaces de manejar contextos de decenas de miles de tokens de manera coherente. Esa capacidad no es una mera mejora incremental: habilita tareas que antes resultaban imposibles o fragmentarias, como razonar sobre bases de código completas, documentos jurídicos extensos o narrativas largas.

Más allá del avance técnico, la lección es conceptual. La frontera del progreso de la inteligencia artificial no parece estar únicamente en modelos cada vez más grandes y costosos, sino en arquitecturas más inteligentes y eficientes, y repensar la propia esencia de cómo procesamos la información abre un horizonte mucho más fértil que buscar el simple escalado infinito. Nos señala, básicamente, que la próxima frontera del progreso puede que no resida únicamente en construir modelos más grandes, sino en formular arquitecturas más inteligentes. Al repensar la propia esencia de cómo las redes neuronales procesan la información, no estamos simplemente optimizando un proceso; estamos expandiendo el horizonte de lo computacionalmente posible, transitando de una era de restricciones a una de abundancia estratégica e inteligente.

Con DeepSeek-V3.2-Exp, China no solo aporta un modelo experimental más en código abierto, sino que redefine el equilibrio entre potencia, eficiencia y accesibilidad, y plantea tanto un reto directo a la manera en que concebimos el futuro de la inteligencia artificial, como una paradoja en la que la geopolítica contamina la ciencia: si el modelo no proviniese de una compañía china, todo Occidente estaría ya seguramente apostando por él. Ya veremos sus consecuencias.

Nota:https://www.enriquedans.com/