El Cambridge Dictionary ha designado «hallucinate», en español «alucinar», como su palabra del año, resaltando la enorme importancia y popularidad de la algoritmia generativa y cómo la palabra ha cobrado un nuevo significado cuando hemos empezado a utilizarla como forma de entender cuando un algoritmo generativo proporciona respuestas incorrectas a una pregunta.

Que un fenómeno como la algoritmia generativa, que alcanzó un millón de usuarios en sus primeros cinco días abierto al público y cien millones en sus primeros dos meses, se convierta en protagonista de la palabra del año puede resultar bastante comprensible: después de todo, muchísimos millones de personas consideran ahora a ChatGPT, a Claude, a Perplexity y a otros algoritmos como asistentes a los que preguntar casi cualquier cosa, a veces de manera muy razonable y en otras pensando absurdamente que les va a servir hasta de médico, de psiquiatra o de consejero de pareja, y muchos se sorprenden cuando les ofrece respuestas que no tienen nada que ver con la realidad.

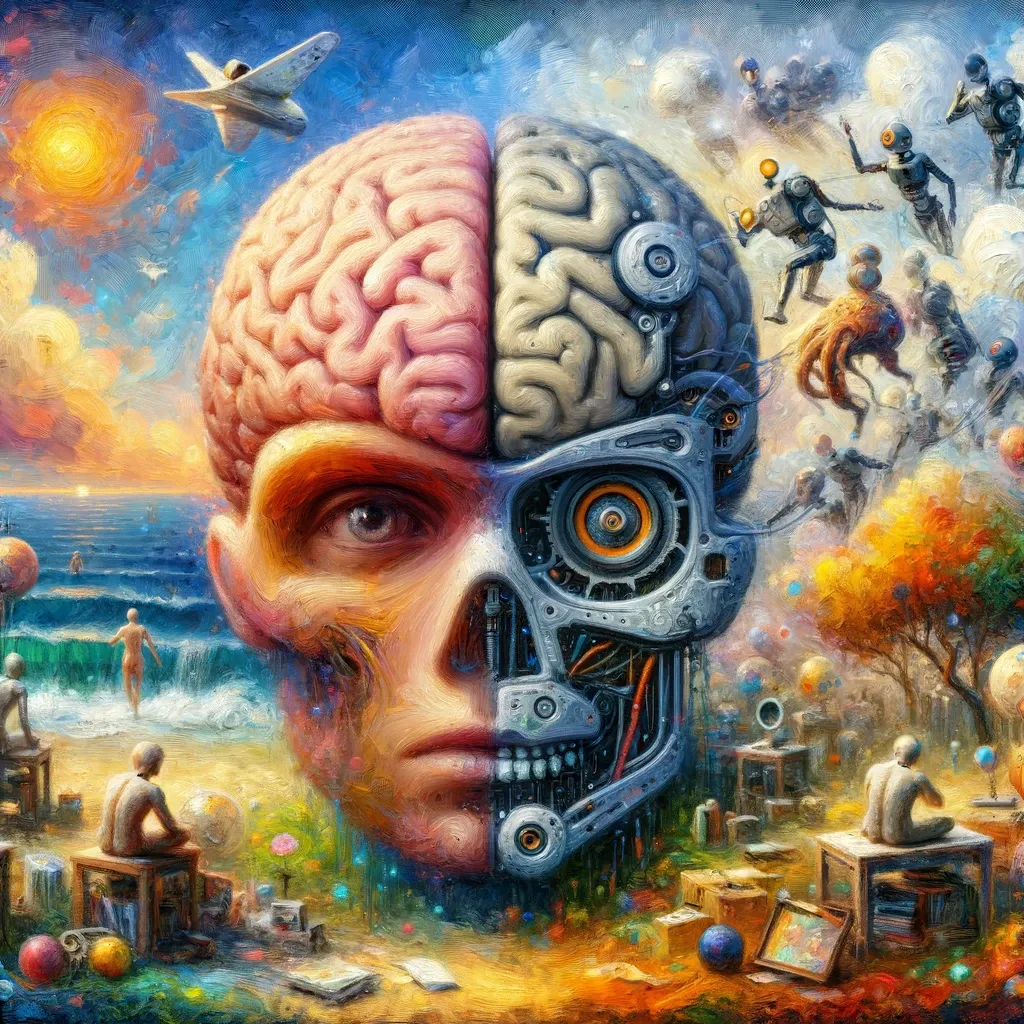

Lo que me sugiere a mí, fundamentalmente, es el interesante paralelismo – no una identidad – entre el funcionamiento de unos algoritmos que, en la práctica, son simplemente estadística elevada a la posibilidad de utilizar una capacidad de procesamiento y una memoria absolutamente brutales, y un cerebro humano que aprende también mediante el uso de estadística.

En realidad, el cerebro humano aprende cosas en función de estadísticas – generalmente bastante simples – y es capaz de deducir de correlaciones de diversos tipos un aprendizaje que le permite explicarse fenómenos o hacer predicciones posteriormente. Pero como en el caso de los algoritmos, también son muchos los casos en los que nuestro cerebro «alucina» no en su acepción original, la de imaginar cosas que no existen o consumir sustancias estupefacientes, sino en la de atribuir a correlaciones aparentes un significado que va más allá del que tenían.

La forma en la que el cerebro humano «alucina» ante determinadas correlaciones puede ser afectada por muchos factores: por nuestra educación y conocimientos de estadística, por nuestros sesgos, etc. Para una persona que no sepa estadística, creer que la lotería de Navidad va a caer en tal o cual número en función de la ocurrencia de los números en los sorteos anteriores puede resultar hasta creíble y determinar cómo gasta (el o ella creerá que no gasta, sino que «invierte») su dinero cuando en realidad se trata de puro azar, del mismo modo que alguien que ve, por ejemplo, a una persona hablando con otra que no es su pareja puede alucinar pensando que tienen un lío.

Las personas se inventan información, a veces intencionadamente y otras veces sin querer. Cuando lo haces sin querer, suele ser el resultado de sesgos cognitivos o “heurísticas”: atajos mentales que desarrollamos a través de experiencias pasadas. Estos atajos nacen de la necesidad: en un momento dado, sólo podemos procesar una cantidad limitada de la información que inunda nuestros sentidos, y recordamos únicamente una fracción de toda la información a la que hemos estado expuestos, que pasamos a considerar representativa del resto. Nuestro cerebro usa asociaciones aprendidas para llenar los vacíos de información y responder rápidamente a cualquier pregunta que se nos presente. Simplemente, trata de adivinar cuál podría ser la respuesta correcta basándose en un conocimiento limitado, y cae en la llamada «confabulación«.

De una correlación se pueden extraer muchas cosas: lo hace nuestro cerebro muy a menudo, y lo hacen ahora también los algoritmos generativos: si no hay correlaciones significativas, tiran de las que no lo son. En realidad, los algoritmos también alucinan y confabulan a menudo (se calcula un 3% de incidencia en el caso de ChatGPT y hasta un 27% en el de Bard) para rellenar los huecos de información que se encuentran, pero no lo hacen para conservar energía, sino para hacer lo que les hemos pedido: generar una respuesta con la información que les ha sido suministrada en su entrenamiento. Podemos trabajar en la mejora del entrenamiento, suministrar información más completa o tratar de solucionarlo en forma de parche con restricciones ad hoc, y aún no está especialmente claro qué va a ocurrir con ellos: si se convertirá en algo que se puede solucionar o si será una característica que siga ahí y que pueda, incluso, dañar la credibilidad de este tipo de asistentes a medio plazo.

La cuestión que se deriva de esto, lógicamente, es qué ocurre cuando planteamos que, por muy eficiente que sea nuestro cerebro, que lo es y mucho, los recursos de computación de un algoritmo generativo crecen a una velocidad brutal, y pueden por tanto utilizar un nivel de sofisticación estadístico que no se limita a regresiones simples y a observaciones puntuales, sino que puede captar relaciones entre variables de todo tipo – incluyendo las latentes – que un cerebro humano nunca podría llegar a capturar.

De una u otra manera, el paralelismo es claro, y debería llevarnos a la reflexión: aunque no se basen en mecanismos idénticos, sí estamos aparentemente recreando un fenómeno, el del aprendizaje, que con sus obvias diferencias – la presencia o ausencia de conciencia o de motivación, entre otras – puede terminar dando lugar a asistentes enormemente potentes, capaces de cambiar ya no nuestra forma de trabajar, sino nuestra manera de entender el mundo. Pocas veces una palabra con una connotación en principio negativa – obviamente, no es bueno que un algoritmo «alucine» – se convierte en una forma tan interesante de entender el paralelismo entre el cerebro humano y la máquina. Y ahí lo dejo para que vayáis alucinando…

Nota:https://www.enriquedans.com/