Google anuncia en una presentación privada a algunos anunciantes titulada «AI-powered ads 2023» que está trabajando en el uso de algoritmos generativos para la incrementar la sofisticación de la personalización de campañas publicitarias.

La idea es que los anunciantes suministren contenido creativo asociado con su oferta, y que los algoritmos generativos de la compañía puedan recombinarlo adecuadamente en función de la información que Google posee de sus usuarios, de la misma forma – según ellos – en que lo podría hacer una agencia creativa.

La idea me parece sencillamente espantosa: por un lado, corre el riesgo de alienar a las agencias, que podrían llegar a verlo como una forma de competencia en el caso de que un cierto número de sus clientes comenzasen a llevar a cabo este tipo de campañas sin su participación, o con una participación sensiblemente más reducida. Por otro, plantea un nuevo tipo de personalización equivalente a introducir muchas más variables en la ecuación, en lo que supone potencialmente una explotación de la información de los usuarios que podría resultar mucho más invasiva.

¿Qué ocurre cuando un algoritmo escoge la mejor manera de ponerte delante un anuncio – su diseño, sus colores, las frases utilizadas, etc. – en función de toda la información que le suministran, y que puede incluir todo lo que Google tiene en sus archivos sobre ti? Un algoritmo es lo que es: la optimización de una función determinada, en este caso, la conversión. El peligro no es, como Google plantea, que al algoritmo le de por «alucinar», sino que haga su trabajo tan bien, que veamos los anuncios como una especie de imagen especular de nosotros mismos, con todo lo que ello puede conllevar.

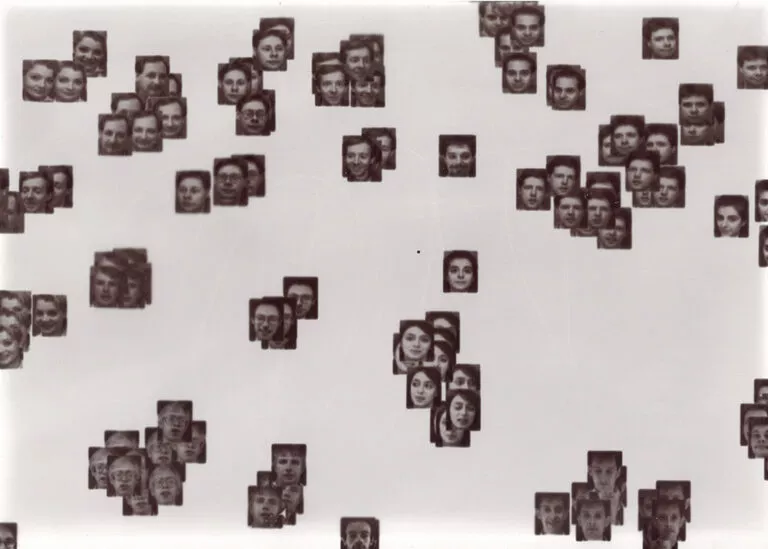

Google plantea la nueva herramienta como una parte integrada en Performance Max, un programa que la compañía ofrece desde el año 2020 que utiliza un algoritmo para determinar en dónde deben ubicarse los anuncios y de qué manera deben gastarse los presupuestos de marketing, además de producir algunos anuncios publicitarios simples. Al incorporar la sofisticación que supone el uso de algoritmos generativos de diversos tipos, Google da un paso más a la hora de personalizar la publicidad: dado que los procedimientos estadísticos y las correlaciones que llevan a cabo estos algoritmos son, en la mayoría de los casos, una caja negra imposible de interpretar, ya veremos con qué nos encontramos a medida que su uso se popularice: ya no campañas que intentan alcanzar a personas a través de diferentes canales, sino directamente distintos anuncios para distintos perfiles, planteados y recombinados algorítmicamente en función de cualquier aspecto de su comportamiento.

Lo que me preocupa, francamente, no son los problemas derivados del funcionamiento del algoritmo o de si «alucina» más o menos, sino los que provienen del hecho de que ese algoritmo utilice variables que no debe, bien porque se las suministren directamente o porque sea capaz de inferirlas mediante los procedimientos estadísticos adecuados. Si el hecho de ser impactados por determinados anuncios ya hace a muchas personas sentirse poco menos que paranoicas, creer que sus dispositivos les espían o hacerse cruces pensando por qué diablos de razones están viendo algo así, lo que puede ocurrir cuando sea un algoritmo generativo el que plantee esos anuncios me da la impresión de que no puede ser nada bueno. Es algo parecido a lo que estamos a punto de ver que ocurre con el spam: cuanto mejor funcionen sus algoritmos, mucho peor para todos.

Es más: si ya existe una significativa corriente de opinión que defiende que la publicidad hipersegmentada es nociva y debería ser prohibida, veremos qué ocurre cuando esa hipersegmentación la lleven a cabo algoritmos generativos alimentados con todos los datos que determinadas compañías llevan años recopilando sobre nosotros, en función de nuestros hábitos y comportamientos ya no en sus servicios, sino en todo lo largo y ancho de la web, y en función también de los múltiples – y posiblemente inquietantes – errores que puedan cometer.

¿En qué momento tuvo lugar algún tipo de consenso social en función del cual pasamos a poder segmentar la publicidad ya no en función de unas pocas variables evidentes, sino de prácticamente cualquier cosa que hacemos o que hicimos un día? ¿Tiene sentido que una serie de algoritmos se dediquen a convertirse en rifles de francotirador con un mira telescópica ultra-precisa al servicio de un anunciante determinado?

Sinceramente, prefiero ver a los algoritmos dedicados a otras cosas.

Nota:https://www.enriquedans.com/