El anuncio de una nueva oleada de salidas de directivos clave en OpenAI – la Chief Technology Officer, Mira Murati, el Chief Research Officer, Bob McGrew, y el Head of Post-Training, Barret Zoph – ha provocado, además de un caos importante, un montón de especulaciones sobre lo que puede estar ocurriendo en la que es, sin ninguna duda, una de las compañías más influyentes del mundo de cara al futuro, bajo el liderazgo de Sam Altman.

Estas salidas, sin duda importantes en la operativa de la compañía, se unen a las también recientes de Ilya Sutskever y Jan Leike, del equipo de alineamiento y seguridad; de Gretchen Krueger, de Policy Research; de Daniel Kokotajlo y William Saunders, de Seguridad; de John Schulman, co-fundador de la compañía y ChatGPT Architect; y de Greg Brockman, cofundador y Presidente. Algunos de ellos se han ido a crear sus propias iniciativas, otros se han unido a competidores como Anthropic, y otros están aún por anunciar sus derroteros. Parece claro que el hecho de venir de una compañía como OpenAI abre todas las puertas y permite salir de ella sin ningún tipo de miedo al vacío.

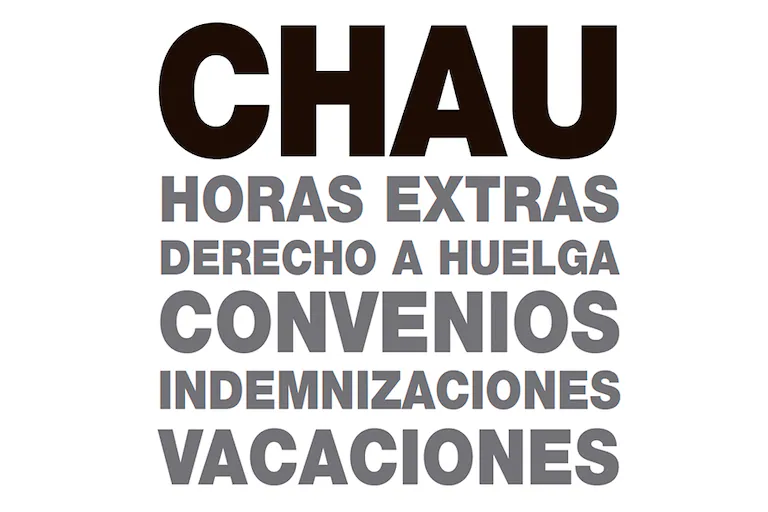

Semejante ola de salidas de directivos en OpenAI parece estar impulsada por una combinación de factores internos y externos, que reflejan importantes tensiones dentro de la empresa a medida que amplía sus operaciones. Aparentemente, una de las principales fuentes de tensión es la transición de la empresa desde la original organización de investigación sin ánimo de lucro, a convertirse en una entidad con una orientación más comercial. Este cambio hacia la obtención de beneficios habría provocado fricciones entre los directivos más centrados en el desarrollo ético de la IA, y los que presionan por un crecimiento más rápido y la generación de ingresos.

Varios directivos, incluido el cofundador Ilya Sutskever y el experto en seguridad Jan Leike, salieron debido a las preocupaciones de que OpenAI estaba priorizando los «productos brillantes» por encima de la investigación crítica de seguridad, en particular la relacionada con la alineación del desarrollo de la llamada Inteligencia Artificial General (AGI).

Además, las presiones financieras de la empresa se están volviendo cada vez más pronunciadas. A pesar de generar ingresos significativos, se sabe que OpenAI está quemando mucho más dinero de lo que gana, lo que ha provocado discusiones sobre posibles nuevas rondas de inversión y una mayor comercialización para generar más fuentes de ingresos a corto plazo. Esta tensión entre el desarrollo ético de la IA y la búsqueda de rentabilidad es considerado por muchos un factor clave tras las salidas de figuras como Mira Murati y John Schulman.

Las salidas también siguen a una agitación de liderazgo anterior, incluida la breve destitución del director ejecutivo Sam Altman en 2023, que ha creado inestabilidad dentro de la organización. Estos factores están contribuyendo a un período desafiante para OpenAI mientras trata de navega el delicadísimo equilibrio entre innovación, seguridad y éxito comercial.

En cualquier caso, la brutal oleada de salidas de directivos de la compañía presenta varias amenazas, tanto inmediatas como a largo plazo, y tanto para OpenAI como para su director ejecutivo y figura pública central, Sam Altman, que incluyen tanto desafíos internos, como impactos reputacionales y presiones competitivas.

Desde la óptica de la inestabilidad interna y del liderazgo, la pérdida de figuras clave como John Schulman y Mira Murati genera inquietudes sobre la continuidad del liderazgo y la retención de talento. En ambos casos hablamos de personas que desempeñaron papeles cruciales en la creación de algunas de las tecnologías centrales de OpenAI, como la aplicación del aprendizaje de refuerzo y el propio desarrollo de ChatGPT como producto. Como resultado, OpenAI podría enfrentarse a dificultades para mantener su trayectoria actual y seguir el ritmo de las innovaciones en un panorama de la inteligencia artificial en muy rápida evolución. Las discontinuidades de liderazgo también podrían provocar una disminución de la moral, ya que los empleados pueden perder la confianza en la estabilidad de la organización y la visión a largo plazo.

Reputacionalmente, OpenAI ha tratado en todo momento de posicionarse como líder en el desarrollo responsable de la inteligencia atificial. Pero las salidas precisamente de expertos en seguridad y alineación como Ilya Sutskever y Jan Leike indican crecientes tensiones internas sobre la priorización de la comercialización sobre la seguridad de la empresa. Esas salidas, junto con los comentarios críticos de algunos ex-directivos en ese sentido, podrían erosionar la reputación de OpenAI en materia de investigación ética y responsable en inteligencia artificial, y hacerla vulnerable al escrutinio público o, incluso, a posibles intervenciones regulatorias. Además, esa pérdida de confianza puede llegar a obstaculizar las asociaciones y ralentizar las colaboraciones futuras con investigadores e instituciones que aspiren a priorizar la seguridad del desarrollo y de las posibles consecuencias de la inteligencia artificial.

La evolución de OpenAI hacia un modelo de negocio comercial y con ánimo de lucro ya ha provocado conflictos internos y externos. A medida que la empresa busca nuevas rondas de financiación y trata de aumentar su valoración, potencialmente hasta 150,000 millones de dólares, se enfrenta a un delicado equilibrio entre la rentabilidad y el desarrollo ético de la inteligencia artificial. Competidores como Anthropic, fundada por ex-empleados de OpenAI, están atrayendo a los mejores talentos y posicionándose como alternativas sólidas centradas en la seguridad, lo que intensifica aún más ese ya de por sí brutal panorama competitivo.

Además, a pesar de los éxitos comerciales de OpenAI y del crecimiento de las suscripciones de usuarios, es evidente que la empresa está gastando significativamente más de lo que gana, con costes completamente descontrolados que superan los $7,000 millones al año. Ese altísimo volumen de gastos presiona a OpenAI para que comercialice rápidamente sus tecnologías y obtenga financiación adicional, lo que puede llevar a decisiones apresuradas que prioricen los objetivos financieros a corto plazo sobre la seguridad y la innovación a largo plazo. Los desafíos financieros también podrían limitar su capacidad para atraer y retener talento de primer nivel, sobre todo si el futuro financiero de la empresa se vuelve incierto y ven peligrar la valoración de sus stock options.

Todo esto, evidentemente, supone una amenaza para el liderazgo de Sam Altman, que ya tuvo que enfrentarse a desafíos, incluida su breve destitución como CEO en 2023, que dejaron una marca en la confianza interna y una fuerte división en bandos en la compañía. El éxodo de los altos directivos puede ahora generar más dudas sobre su capacidad para dirigir la empresa en una dirección que equilibre la innovación, la seguridad y la rentabilidad. Si además van surgiendo cada vez más dudas sobre el rendimiento de OpenAI, aumentan las críticas públicas debido a preocupaciones éticas, o la compañía termina poniéndose en el foco de los reguladores, Altman podría fácilmente encontrarse bajo un nuevo escrutinio tanto de la junta directiva como de unos inversores externos muy fuertes y con una importante capacidad de decisión.

Además de haber disparado la actual era de la inteligencia artificial generativa con el lanzamiento de Dall·E y de ChatGPT en 2022, OpenAI es, sin duda, una de las compañías que más tienen que decir sobre su futuro. Pero su capacidad de marcar ese futuro va a depender de su estabilidad, de una marcha coherente y de su capacidad para seguir siendo considerada como una brújula fiable en términos de tendencias. Pon eso en peligro, y estarás haciendo peligrar mucho más que las inversiones de unos pocos: podrías terminar dando lugar a terremotos mucho más fuertes, que podrían llegar incluso al nivel geopolítico. Ya veremos cómo sigue evolucionando la cuestión.

Nota:https://www.enriquedans.com/